İsrail istihbarat servislerinin 7 Ekim 2023 tarihinde Hamas'ın saldırısı sonrası yaşadıkları feci başarısızlığı telafi ettiklerine ve istihbarat yeteneklerindeki büyük gelişmenin İsrail'in Hamas ve Hizbullah'ın üst düzey liderlerinin izini sürmesine ve öldürmesine hızla yardımcı olduğuna şüphe yok.

Bunun yanı sıra bu iki silahlı grubun daha birçok askeri ve siyasi lideri ve yetkilisi öldürüldü.

İsrail'in istihbarat yeteneklerini kısa sürede nasıl geliştirebildiği uzmanlar arasında yıllarca tartışılacak bir konu olacak.

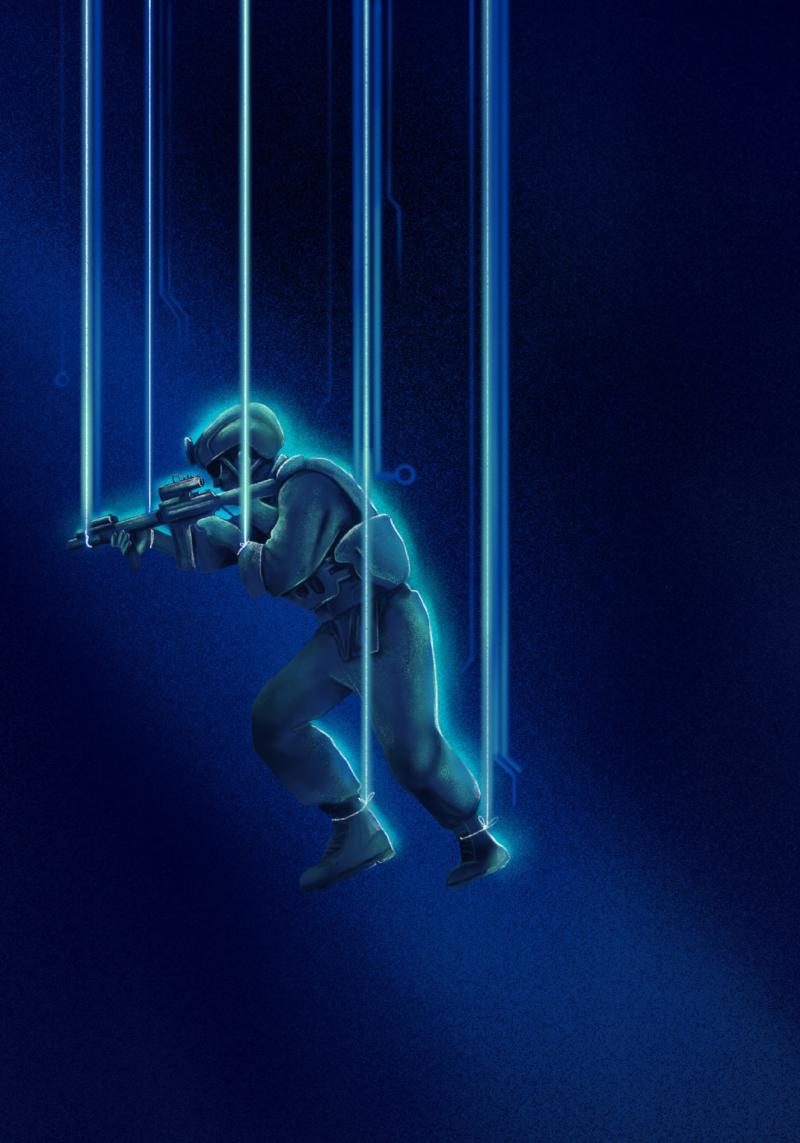

Yapay zeka (AI) ve İsrail'in Gazze Şeridi'ndeki ve diğer bölgelerdeki askeri hedeflerine ulaşmak için bu teknolojiyi istihbarat döngüsünde nasıl kullandığı da bu tartışmanın başlıca konularından biri.

Kısa bir süre önce Tokyo Üniversitesi'ndeki Eğilimler Araştırma ve Danışmanlık Merkezi ile Bilim ve Teknolojide İleri Araştırma Merkezi'nin ortak konferansında yapay zekâ ve savunma üzerine bir sunum yaptım.

Japonya'ya gelmeden önce, yapay zekanın savunmada vadettiklerine dair adil bir anlayış geliştirdiğimi düşünüyordum.

Baş teknoloji sorumlusu Schuyler Moore da dahil olmak üzere ABD Merkez Komutanlığı (CENTCOM) personeliyle yaptığım araştırmalar ve kişisel görüşmeler yoluyla yapay zekanın kullanım alanları hakkında kendimi eğitmiştim.

ABD Donanması 5'inci Filosu'nun deniz güvenliğini sağlamaya yönelik zorlu görevinde yapay zekayı nasıl kullandığını gördüm.

Ancak Tokyo'da, gerçek birer bilim insanı olan Japon meslektaşlarımdan yapay zekanın günlük hayatımızdaki, özellikle de savunma alanındaki potansiyelini keşfetmemizin hala sınırlı olduğunu öğrendim.

Bu da yapay zekayı korkutucu olduğu kadar heyecan verici kılıyor.

Hamas hedefleri

İsrail ve 5'inci Filo örneklerine geri dönelim ve bunları daha geniş bir bağlama oturtalım.

İsrail, 7 Ekim'den kısa bir süre sonra, Hamas Hareketi'ne karşı hedefler geliştirmek için yapay zekayı kullanmaya başladı.

Bu süreç, savaş uzadıkça ve Hamas'ın askeri yeteneklerini azaltmaya yönelik siyasi baskı arttıkça yoğunlaştı.

fazla oku

Bu bölüm, konuyla ilgili referans noktalarını içerir. (Related Nodes field)

Yapay zeka, İsrail'in askeri hedef geliştirmesinin tüm aşamalarında önemli bir rol oynadı. İsrail ordusunun askeri birimi Birim 8200 "Lavender" adlı bir program aracılığıyla Hamas ve diğer silahlı grupların potansiyel üyelerine ait devasa bir veri tabanı oluşturmayı başardı.

Bu yazılımın mükemmel doğrulukta veriler sunmasa da Lavender'in operatörlerine göre yüzde 90'lık bir doğruluk oranına ulaşıldı.

İsrailliler, Lavender'in yanı sıra, bireylerden ziyade fiziksel altyapıya ilişkin tavsiyelerde bulunan "Gospel" adlı başka bir yapay zeka tabanlı karar destek sistemi de kullanıyorlar.

İsrail, aynı zamanda Gazze Şeridi'ndeki ve Lübnan'daki kişileri hedef almak ve çatışmadan sonra ölüp ölmediklerini teyit etmek için kapalı alan çatışmalarında otonom dronlar kullandı.

İsrail'in Refah'ta bir binaya yönlendirilen ve kısa bir süre sonra öldürülen Hamas'ın Siyasi Büro Başkanı Yahya Sinvar'ı görüntülemek için drone kullanması, yapay zeka destekli angajmanların son örneklerinden biri oldu.

Yapay zekanın İsrail ordusu için binlerce hedef üretebilmesi askeri operasyonlarda temel bir değişimi temsil ediyor.

Ancak İsrailli istihbarat görevlileri ve komutanlarının bu bilgileri kullanma biçimleri derin endişelere yol açmakta ve uluslararası hukukla çelişebiliyor.

Özellikle İsrail'in Gazze Şeridi'nde ve Lübnan'da uluslararası insancıl hukuka bağlılığı zaten son derece tartışmalı bir konuyken yapay zeka destekli muazzam miktarda bilgiye sahip olmak başka bir şey, bunu sorumlu bir şekilde ve uluslararası standartlara ve yasalara uygun olarak kullanmak başka bir şey.

Karar alıcı olarak insan

Ancak İsrail'in Gazze Şeridi'nde ve Lübnan'da öldürdüğü çok sayıda sivil için yapay zekayı suçlamak abesle iştigaldir.

Zira burada asıl rolü, merkezinde insanın olduğu karar verme mekanizması oynuyor.

İsrail, Gazze Şeridi'nde yürüttüğü savaşın ilk aşamalarında hedefleme kriterlerinde esnekliğe giderek normalde isabetli saldırılar sağlayan ve sivillerin zarar görmesini en aza indiren kuralları gevşetti.

Yapay zeka destekli saldırılar insan kaynaklarına daha az ihtiyaç duyarken, "yapılandırılmış" istihbarat operasyonları daha fazla insan gücü ve mali kaynağın yanı sıra hukuki danışmanlığa da ihtiyaç duyuyor.

İsrail'in hiçbir ayrım gözetmeksizin düzenlediği bombardımanlar çok sayıda sivilin hayatını riske attı.

Bu saldırılar, her ne kadar uluslararası toplum tarafından kınanmış ve ABD baskısı nedeniyle savaş sırasında değişmiş olsa da İsrailli yetkililerin rızasıyla gerçekleştirildi.

İsrail tarafından Gazze Şeridi'nde ve Lübnan'da öldürülen çok sayıda sivil için yapay zekayı suçlamak saçma olur. Burada karar almada kilit rolü insan üstleniyor.

İsrail ile Hamas ve Hizbullah arasındaki çatışmaların dışında, bilgi toplama ve işleme süreçlerinin otomatikleştirilmesi süregelen bir gerçeklik haline geldi.

ABD Deniz Kuvvetleri Merkez Komutanlığı, sorumluluğu altındaki karasularını güvence altına almak için yapay zekayı kullanan en önemli örnek olarak karşımıza çıkıyor.

Örneğin, ABD Deniz Kuvvetleri Merkez Komutanlığı Görev Gücü 59, birden fazla sensörden elde edilen ortak bir operasyonel resmi gerçek zamanlı olarak oluşturup güncelleyerek durumsal farkındalığını artırmak için yapay zeka destekli insansız sistemlerle güçlendirilmiş bir görev gücüdür.

Dünyanın dört bir yanındaki orduların, hedeflerine ulaşmak için hem savunma hem de saldırı operasyonlarında yapay zekayı her geçen gün daha fazla kullanması bekleniyor.

Ancak beraberinde bazıları teknik, diğerleri ise yasal ve etik yönlerle ilgili çeşitli zorluklar da geliyor.

Yapay zekanın yetenekleri etkileyici olsa da kusurları da yok değil.

Elbette diğer tüm teknolojiler gibi, geliştiriciler bu kusurları ele almaya devam edecektir.

Örneğin, yapay zeka göründüğü kadar akıllı değil.

Belirli bir görüntüyü işlemekle görevlendirilirse ve bu görev, üzerine inşa edildiği ve geliştirildiği eğitim setinden (setlerinden) biraz saparsa, içeriği doğru bir şekilde tanımlamakta zorlanabilir veya başarısız olabilir.

Kötü aydınlatma, alışılmadık bir açı yahut görüntünün belirsiz bir kısmı sistemin kafasının karışması için yeterli.

Tüm bu kusurlar daha kapsamlı ve spesifik yazılım eğitimi ile giderilebilir, ama buradaki kilit nokta yapay zekanın kendisinden istenenin ötesine geçmeyeceği gerçeğidir.

Bu yüzden insan yazımı ve talimatları kritik önemini halen koruyor.

Sınırlı misyonlar

Yapay zeka çok çalışıyor olsa da birden fazla görevi yönetme becerisi sınırlı.

İstihbarat operasyonları bağlamında, bir insan bir hedefi belirleyebilir, en uygun silahı seçebilir, hedefin yönünü tahmin edebilir ve son olarak onu vurabilir.

Tüm bunlar bir arada gerçekleştirilen birden fazla görevdir.

Tek bir yapay zeka sistemi tüm bu görevleri aynı anda yerine getiremez.

Ancak bir grup yapay zeka sistemi, farklı görevleri üstlenen ayrı modellerle bu görevleri yerine getirebilir.

Fakat burada da bu senkronizasyonu sağlamak büyük bir teknolojik zorluktur ve oldukça pahalıya mâl olur.

Teknolojide henüz bu aşamaya ulaşamadık.

Dünyanın dört bir yanındaki ordular, yapay zekayı daha fazla kullanmak için rekabetçi baskılarla karşı karşıya kalacaklar. Barış, kriz ve savaş durumlarında karar verme konusunda avantaj elde etme arzusu her zaman var olmaya devam edecek.

Yapay zeka olayları bağlamsallaştıramaz ve bağlam ile nedensellik arasındaki farkı ayırt edemez. Bunlar insanlara mahsus becerilerdir.

Örneğin, yapay zekanın tanımaya çalıştığı görüntü, teknoloji için bir gizem olarak kalmaya devam eder.

Ne olduklarını ya da ne anlama geldiklerini anlamadan yalnızca 'görüntü titreşimlerinin' dokusunu ve gradyanlarını analiz edebilir.

Aynı gradyanlar farklı bir bağlamda ortaya çıkarsa, yapay zeka görüntünün bazı kısımlarını yanlış tanımlayabilir.

Yapay zeka örüntüleri tespit etmede son derece başarılı olsad da bunların neden oluştuğunu ya da neye yol açtığını açıklayamaz.

Bir yapay zeka modeli için mantıklı olan, insanlar için mantıksız ya da alakasız olabilir.

Yukarıda bahsedilen zorluklarla birlikte yapay zekanın nasıl karar verdiği önemli bir güvenlik açığı ve potansiyel sorundur.

İnsanların sistemin nasıl karar verdiğini anlamak için yapabilecekleri çok az olduğundan, bir yapay zeka sisteminin içinde olanların çoğu bir kara kutu olarak kalır.

Bu durum, karar alıcı veya çıktıları kritik karar alma süreçlerinde kullanılanlar gibi yüksek riskli sistemler için ciddi bir sorun teşkil ediyor.

Bir sistemi gözden geçirip inceleyebilmek ve neden hata yaptığını görebilmek hem yasal hem de etik açıdan son derece önemli.

Ancak tüm bu eksikliklere, zorluklara ve belirsizliklere rağmen dünyanın dört bir yanındaki ordular, yapay zekayı daha fazla kullanmak için rekabetçi baskılarla karşı karşıya kalacaklar.

Barış, kriz ve savaş durumlarında karar verme konusunda avantaj elde etme arzusu her zaman var olmaya devam edecek.

Özellikle bu son derece rekabetçi süper güç ortamında kimse geride kalmak istemez.

Son olarak, eğitim ve öğretimdeki iyileştirmeler, yapay zeka ile ilgili bazı güvenlik açıklarının ve risklerin ele alınmasına ve bunların azaltılmasına yardımcı olabilir.

Askeri alanda, hata olasılığını ve bunların yansımalarını en aza indirmek için daha fazla insan denetlemesi ve müdahalesi gerekiyor.

Esas olansa yapay zeka sistemleri için standartları ve gereksinimleri insanların belirlemesidir.

*Bu makalede yer alan fikirler yazara aittir ve Independent Türkçe'nin editöryal politikasını yansıtmayabilir.

Bu makale Independent Türkçe için Londra merkezli Al Majalla dergisinden çevrilmiştir.